TT-Forge™

TT-Forge™

투명하고 자유롭게 확장 가능한 공개 플랫폼

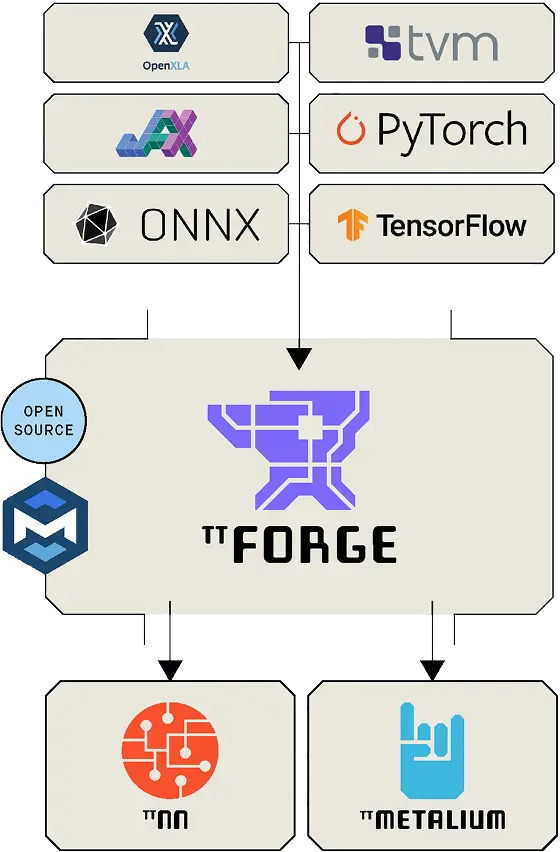

TT-Forge™는 Tenstorrent의 MLIR 기반 컴파일러로, 도메인별 컴파일러부터 맞춤형 커널 생성기에 이르기까지 다양한 ML 프레임워크와 호환되도록 설계되었습니다. TT-Forge™는 Tenstorrent의 기존 AI 소프트웨어 생태계와 기본적으로 통합되어 있어 손쉽게 개발할 수 있습니다.

MLIR: AI 컴파일에 대한 통합 접근 방식

혁신을 위한 설계

다중 프레임워크 프런트엔드 지원을 통한 일반적인 확장성

tt-torch

tt-torch는 MLIR 네이티브 오픈소스 PyTorch 2.X 및 torch-mlir 기반 프런트엔드입니다. tt-mlir에 안정적인 HLO(SHLO) 그래프를 제공합니다.

PT2.X 컴파일을 통해 PyTorch 모델을 수집하고 torch-mlir(ONNX->SHLO)을 통해 ONNX 모델을 수집하는 것을 지원합니다.

또한 PyTorch 그래프를 개별 작업으로 분해하여 병렬화된 버그나 누락된 작업을 쉽게 발견할 수 있습니다.

tt-forge-Fe

TT-Forge-FE는 딥 러닝 모델을 위한 계산 그래프를 최적화하고 변환하여 성능과 효율성을 향상시키도록 설계된 그래프 컴파일러입니다.

TVM(tt-tvm)을 통해 PyTorch, ONNX, TensorFlow 및 유사한 ML 프레임워크의 수집을 지원합니다.

TVM IR을 기반으로 다양한 프레임워크의 그래프를 개별 작업으로 분해하여 모델 구축 작업을 데이터 중심으로 수행할 수 있습니다.

tt-xla

tt-xla는 PJRT 인터페이스를 활용하여 JAX(그리고 향후 다른 프레임워크), tt-mlir 및 Tenstorrent 하드웨어를 통합합니다.

tt-mlir 컴파일러에 StableHLO(SHLO) 그래프를 제공하여 jit 컴파일을 통해 JAX 모델을 수집할 수 있도록 지원합니다.

tt-xla 플러그인은 JAX에 기본적으로 로드되어 tt-mlir 컴파일러와 런타임으로 JAX 모델을 컴파일하고 실행합니다.

특징

성능

최적화된 컴파일 및 커스텀 언어(TTIR, TTNN, TTKernel)를 통해 효율적인 실행이 가능해져 Tenstorrent 하드웨어에서 추론 및 학습 성능이 극대화됩니다. tt-explorer를 통해 성능 최적화가 간소화되었습니다.

범용성